La calibración del micrómetro es clave.

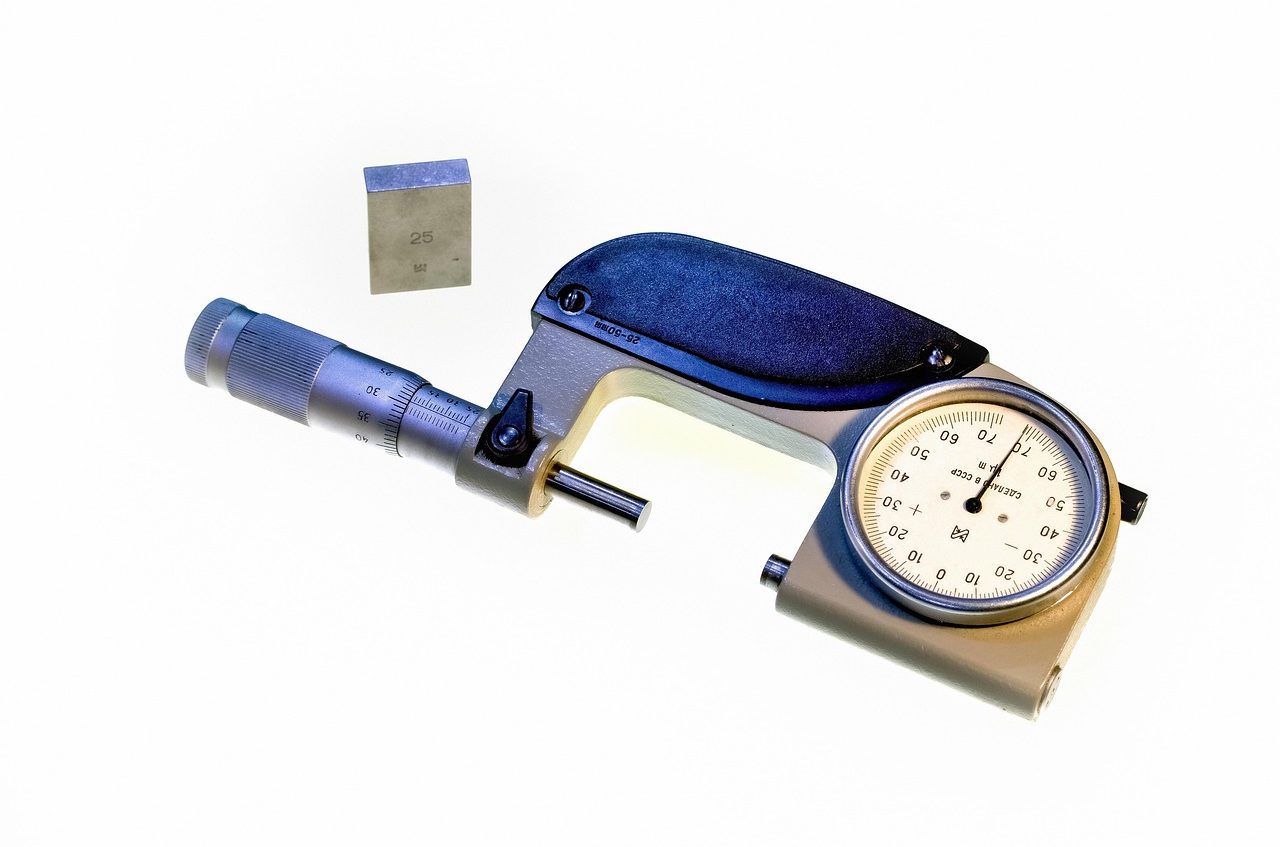

Un micrómetro es una herramienta que se emplea para la medición de una línea o de un ángulo muy pequeños de manera precisa. También conocido como palmer, calibre Palmer o tornillo de Palmer, dispone de un tornillo micrométrico que permite medir en un rango de milésimas o centésimas de milímetro.

El tornillo del micrómetro tiene una escala en su contorno. Para realizar la medición, los extremos del instrumento deben aproximarse de forma progresiva hasta llevar a cabo la estimación deseada.

Temas

Temas Resumen

ResumenHistoria del micrómetro

A lo largo del Renacimiento y la Revolución industrial surgió la necesidad de realizar mediciones con especial precisión. Por aquel entonces, no existían instrumentos capaces de medir unidades tan pequeñas, pero las exigencias del mercado impulsaron su creación.

Entre las primeras pruebas de herramientas capaces de escalar con precisión grandes distancias a la lente de un telescopio se encuentra la que desarrolló Galileo Galilei en el siglo XVII para determinar cuán lejos se encontraba Júpiter de sus satélites.

En 1640, en tanto, William Gascoigne inventó el tornillo micrométrico, que ofrecía ventajas por sobre la escala de Vernier para la medición de distancias angulares a través del microscopio.

Más adelante, el inventor inglés Henry Maudslay creó uno de los primeros micrómetros en 1829, con base en el sistema métrico de su nación. Luego el francés Jean Laurent Palmer optimizó el instrumento de medición, apelando a un tornillo micrométrico manual.

Los micrómetros suelen usarse para el control de calidad.

Sus características

Con el tiempo otros científicos incorporaron mejoras en estos utensilios hasta que se alcanzó la forma actual del micrómetro. Lo que hace el dispositivo es convertir las distancias ínfimas en rotaciones más grandes que pueden leerse en una escala de medición dada. Gracias al tornillo micrométrico roscado de su interior, se consigue una gran precisión.

Los micrómetros apelan al llamado principio de Abbe para llevar a cabo las mediciones. Esto supone que su escala y la posición del elemento a medir tienen que ser colineales.

Al realizar la medición, los extremos del micrómetro se van acercando hasta «encerrar» al objeto. Es clave que la torsión del tornillo micrométrico sea limitada para evitar que se aplica una fuerza excesiva, la cual provocaría que se pierda exactitud.

En los primeros micrómetros, el resultado de la medición se observaba en un tambor graduado que mostraba las marcas de escala. Con el tiempo se incorporó una escala de Vernier o nonio, que permite la lectura de la medida mediante una fracción del registro de la escala de menor tamaño. La evolución de los micrómetros continuó con la innovación tecnológica que permitió la digitalización y el uso de pantallas LCD que exhiben las marcas.

Las mediciones industriales se realizan generalmente con micrómetros.

Tipos de micrómetros

Existen varios criterios que podemos usar para clasificar los micrómetros. Por ejemplo, si observamos la tecnología usada a la hora de fabricarlos, tenemos los siguientes modelos:

- Mecánicos: se basan únicamente en elementos mecánicos. Cabe señalar que son los más antiguos,

- Electrónicos: en su manufactura se usan elementos electrónicos y, por lo general, tecnología digital.

De acuerdo con la unidad de medida, el micrómetro puede pertenecer a distintos sistemas:

- Sistema decimal: la unidad de longitud que usa es el milímetro.

- Sistema inglés: usa un divisor de la pulgada.

Según la normalización, asimismo, el micrómetro puede ser:

- Estándar: sus aplicaciones son generales.

- Especial: se fabrican para trabajos específicos de medición, ya sea en la fabricación o en la verificación de ciertas piezas. Por esta razón, su apreciación y su amplitud de medidas son particulares.

En cuanto a la clase de medidas que pueden tomar, se reconocen los siguientes tipos de micrómetros:

- De profundidad: Mide la profundidad de huecos y ranuras.

- De interiores: Permite la medición de la dimensión interna de un elemento.

- De exteriores: Orientado al cálculo de la medida de las dimensiones externas de un objeto.

Como unidad de longitud

Micrómetro, por otra parte, es sinónimo de micra o micrón. Se trata de una unidad de longitud de símbolo μ que equivale a la millonésima parte de un metro: 0,001 mm.

El uso de esta unidad resulta conveniente para aludir a elementos muy pequeños. El diámetro del pelo del ser humano, por ejemplo, se mide en micrómetros: cada cabello tiene un diámetro de unos 70 μ.

Esta unidad de medida es la más pequeña del ámbito de la fabricación mecánica. Se usa para expresar las variaciones de tamaño que se permiten en el proceso de diseño de las piezas, un concepto que se denomina tolerancia de cotas. No obstante, hay que considerar que existen unidas aún más pequeñas, como el nanómetro, equivalente a la milmillonesima parte de un metro.

Etimología de micrómetro

Con respecto a su etimología, esta acepción del término micrómetro se originó en el griego, específicamente en el género gramatical neutro de micrós, un adjetivo que se puede traducir como «pequeño».

Si usamos el sinónimo micrón, el plural correspondiente es micrones. Para micra, en cambio, debemos usar micras; cabe mencionar que en griego no cambia, sino que se mantiene micra. Por este motivo, si habláramos con total rigor lingüístico deberíamos usar este término sin alteración para el plural de micrómetro, a menos que digamos micrómetros.